瑞芯微RKNPU开发全指南:从环境搭建到性能优化,一文搞定边缘AI部署

在边缘AI领域,瑞芯微(Rockchip)的RKNPU凭借高性能、低功耗的特性,成为很多嵌入式开发者的首选。无论是RK3588的3核NPU(算力达6TOPS),还是RV1106的轻量化NPU,都需要通过RKNN SDK实现模型部署。今天这篇文章,我们就从SDK核心组件、开发全流程、进阶优化到避坑指南,手把手教你搞定RKNPU开发!

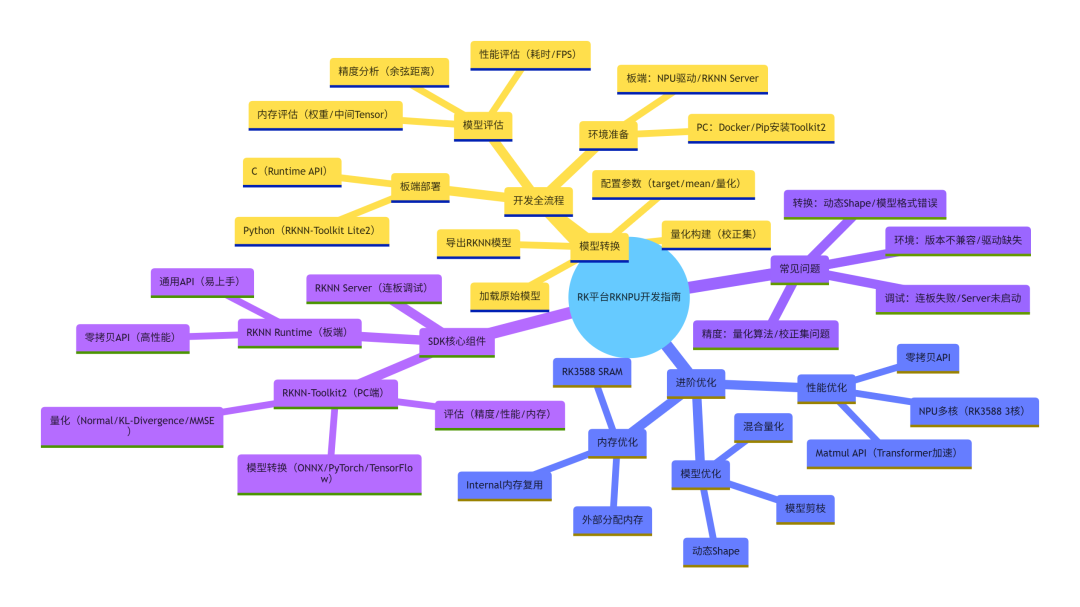

一、先搞懂:RKNN SDK核心组件

RKNN SDK不是单一工具,而是一套“PC端工具链+板端运行时”的完整生态。先理清这3个核心组件的分工,后续开发才不会乱:

1.核心组件交互图

2.组件详解

•RKNN-Toolkit2(PC端)

开发者的“模型加工厂”,主要负责:

◦模型转换:支持ONNX、PyTorch、TensorFlow等主流框架转RKNN格式;

◦量化优化:将FP32模型量化为INT8(支持Normal/KL-Divergence/MMSE三种算法),减小模型体积、提升推理速度;

◦评估分析:在模拟器或连板状态下,分析模型精度(余弦距离)、性能(单帧耗时)、内存(权重/中间Tensor占用)。

•RKNN Runtime(板端)

模型的“推理引擎”,分两种API:

◦通用API:易上手,数据预处理(归一化、格式转换)在CPU完成,适合快速验证;

◦零拷贝API:高性能,预处理在NPU完成,数据无需CPU-NPU拷贝(直接用物理地址/fd),适合摄像头、视频解码等低延迟场景。

•RKNN Server(板端)

连板调试的“桥梁”,运行在开发板后台,接收PC端Toolkit2的指令,转发数据/推理结果,支持多设备管理。

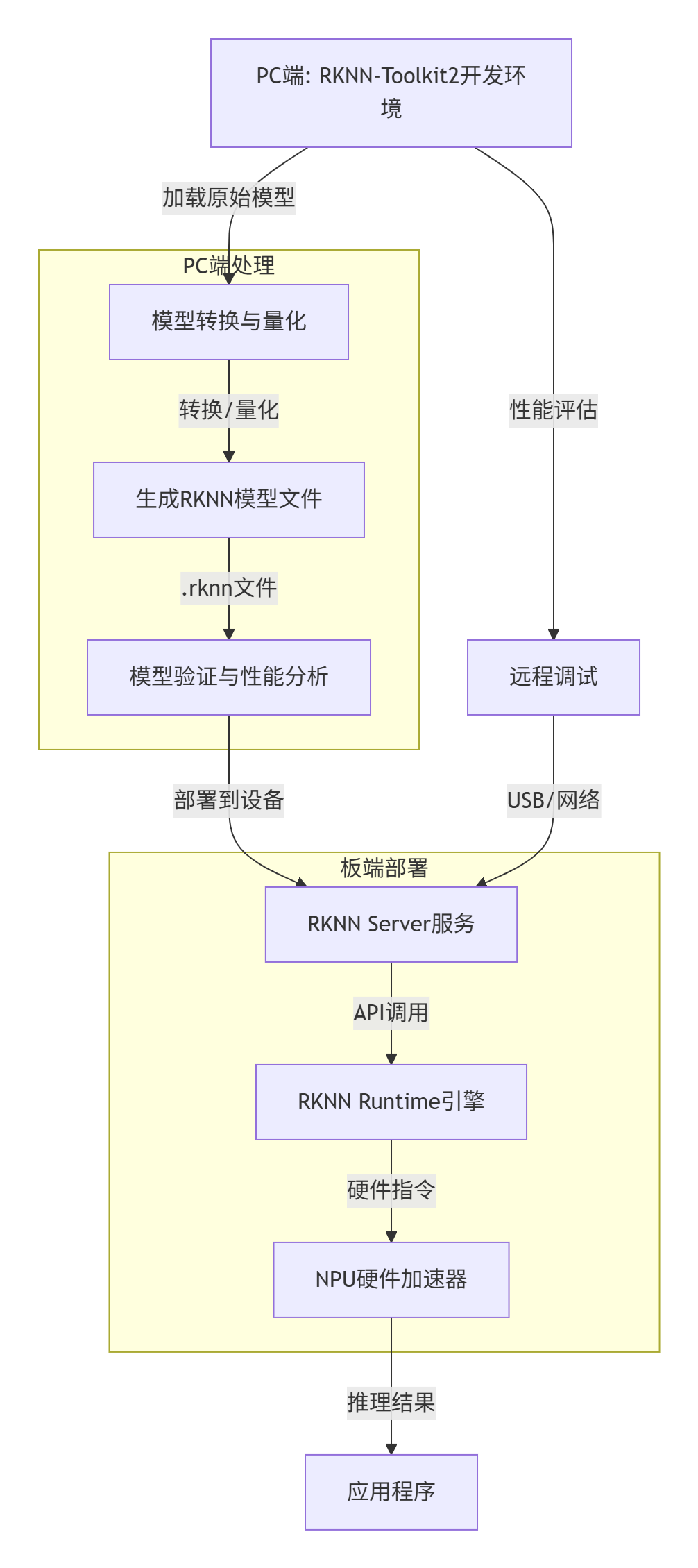

二、开发全流程:从0到1部署一个模型

以“MobileNet图像分类模型”为例,带大家走一遍完整开发流程,关键步骤附实操代码和注意事项:

1.开发全流程图表

2. step 1:环境准备

(1)PC端:安装RKNN-Toolkit2

推荐用Docker(避免环境冲突),命令如下:

# 1. 安装Docker并添加用户组sudo groupadd dockersudo usermod -aG docker$USERnewgrp docker# 2. 加载RKNN-Toolkit2镜像(镜像从瑞芯微网盘下载)docker load --input rknn-toolkit2-x.x.x-cpxx-docker.tar.gz# 3. 启动容器(映射USB和示例代码)docker run -t -i --privileged -v /dev/bus/usb:/dev/bus/usb -v /your/examples:/examples rknn-toolkit2:x.x.x-cpxx /bin/bash

(2)板端:确认NPU环境

开发板必须满足3个条件:

•NPU驱动版本≥0.9.2(查询命令:cat /sys/kernel/debug/rknn/driver_version);

•RKNN Server已启动(查询命令:ps | grep rknn_server,未启动则执行restart_rknn.sh);

•Runtime库版本与Toolkit2匹配(如Toolkit2 v2.0.0需librknnrt.so v2.0.0)。

3. step 2:模型转换(核心步骤)

以ONNX模型为例,用Toolkit2的Python接口实现转换:

fromrknn.apiimportRKNN# 1. 初始化RKNN对象rknn = RKNN(verbose=True)# 2. 配置转换参数(目标平台、均值/归一化、量化)rknn.config(mean_values=[[103.94,116.78,123.68]], # 与训练时一致std_values=[[58.82,58.82,58.82]],target_platform='rk3588', # 目标硬件(如rk3566、rv1106)quantized_algorithm='normal', # 量化算法do_quantization=True# 开启量化)# 3. 加载ONNX模型ret = rknn.load_onnx(model='./mobilenet_v2.onnx')# 4. 量化构建(需准备校正集dataset.txt,每行1张图片路径)ret = rknn.build(do_quantization=True, dataset='./dataset.txt')# 5. 导出RKNN模型ret = rknn.export_rknn('./mobilenet_v2.rknn')# 6. 释放资源rknn.release()

关键注意点:

•校正集(dataset.txt)需覆盖业务场景(如分类模型需包含所有类别图片),数量建议20-200张;

•目标平台(target_platform)必须与开发板一致,否则模型无法运行(RK3566/3568通用,RK3588/3588S通用)。

4. step 3:模型评估(避坑关键)

转换后的模型,必须先评估再部署,避免“能跑但精度/性能不达标”:

# 1. 初始化运行时(连板评估,target设为开发板型号)ret= rknn.init_runtime(target='rk3588', device_id='515e9b401c060c0b')# 2. 精度分析(对比量化模型与浮点模型的每层误差)ret= rknn.accuracy_analysis(inputs=['./test.jpg'], target='rk3588')# 3. 性能评估(输出单帧耗时、FPS、每层算子耗时)perf_detail= rknn.eval_perf()# 4. 内存评估(输出权重、中间Tensor内存占用)mem_detail= rknn.eval_memory()

评估结果解读:

•精度:余弦距离越接近1(如0.999),误差越小;

•性能:RK3588运行MobileNetV2,INT8量化后FPS可达100+;

•内存:权重内存≈3.5MB,总内存≈5.4MB(符合边缘设备需求)。

5. step 4:板端部署(C/Python任选)

(1)Python部署(快速验证,用RKNN-Toolkit Lite2)

from rknn.api import RKNNLite# 1. 初始化RKNNLite对象rknn_lite = RKNNLite(verbose=True)# 2. 加载RKNN模型ret = rknn_lite.load_rknn('./mobilenet_v2.rknn')# 3. 初始化运行时(多核配置:RK3588可设NPU_CORE_0_1_2)ret = rknn_lite.init_runtime(core_mask=RKNNLite.NPU_CORE_ALL)# 4. 预处理输入图片img = cv2.imread('./test.jpg')img = cv2.cvtColor(img, cv2.COLOR_BGR2RGB)img = np.expand_dims(img, 0)# 5. 推理outputs = rknn_lite.inference(inputs=[img])# 6. 后处理(输出TOP5类别)show_top5(outputs)# 7. 释放资源rknn_lite.release()

(2)C部署(高性能,用RKNN Runtime)

核心流程:初始化模型→设置输入→推理→获取输出→释放资源,关键代码片段:

intmain(){rknn_context ctx;// 1. 初始化模型ret =rknn_init(&ctx, model_buf, model_len,0,NULL);// 2. 查询输入输出属性rknn_input_output_num io_num;rknn_query(ctx, RKNN_QUERY_IN_OUT_NUM, &io_num,sizeof(io_num));// 3. 设置输入数据rknn_input inputs[io_num.n_input];inputs[0].index =0;inputs[0].type = RKNN_TENSOR_UINT8;inputs[0].fmt = RKNN_TENSOR_NHWC;inputs[0].buf = img_data;inputs[0].size = img_size;rknn_inputs_set(ctx, io_num.n_input, inputs);// 4. 推理rknn_run(ctx,NULL);// 5. 获取输出rknn_output outputs[io_num.n_output];rknn_outputs_get(ctx, io_num.n_output, outputs,NULL);// 6. 后处理post_process(outputs);// 7. 释放资源rknn_outputs_release(ctx, io_num.n_output, outputs);rknn_destroy(ctx);return0;}

三、进阶优化:让模型跑更快、更省内存

掌握以下技巧,能让RKNPU性能翻倍、内存占用减半,尤其适合边缘设备:

1.性能优化

(1)NPU多核配置(RK3588/RK3576专属)

RK3588有3个NPU核,RK3576有2个,通过core_mask设置多核运行:

# Python(Toolkit2)rknn.init_runtime(target='rk3588', core_mask=RKNN.NPU_CORE_0_1_2)# C APIrknn_set_core_mask(ctx, RKNN_NPU_CORE_0_1_2);

效果:MobileNetV2在RK3588上,多核运行比单核快2.5倍。

(2)零拷贝API(减少DDR带宽消耗)

适合摄像头、视频解码等场景,数据直接用物理地址:

// 1. 创建外部分配内存(用物理地址)rknn_tensor_mem* input_mem =rknn_create_mem_from_phys(ctx, phys_addr, virt_addr, size);// 2. 设置零拷贝输入rknn_set_io_mem(ctx, input_mem, &input_attr);// 3. 推理rknn_run(ctx,NULL);

效果:数据拷贝耗时减少80%,端到端延迟降低30%。

2.内存优化

(1)RK3588 SRAM使用(减轻DDR压力)

RK3588有956KB SRAM,可分配给NPU存中间Tensor:

// 初始化时开启SRAMret =rknn_init(&ctx, model, size, RKNN_FLAG_ENABLE_SRAM,NULL);

查询SRAM使用:cat /sys/kernel/debug/rknn/mm,可看到已用/剩余大小。

(2)动态Shape(单模型支持多分辨率)

无需生成多个模型,一个模型支持多种输入尺寸(如224x224、192x192):

# 配置动态输入dynamic_input = [[[1,3,224,224]],[[1,3,192,192]]]rknn.config(dynamic_input=dynamic_input)

场景:NLP模型(可变序列长度)、图像分割(可变分辨率)。

3.模型优化

(1)混合量化(精度与性能平衡)

对精度敏感的层(如输出层)用FP16,其他层用INT8:

# 混合量化配置文件custom_quantize_layers:Conv__350 float16 # 指定层用FP16quantize_parameters:FeatureExtractor/Convqtype: asymmetric_quantizeddtype: int8

(2)模型剪枝(无损减小体积)

开启model_pruning,自动移除冗余权重:

rknn.config(model_pruning=True)

效果:MobileNetV2权重减少6.9%,运算量减少13.4%,精度无损失。

四、避坑指南:开发者常踩的5个坑

1.连板调试失败

◦原因:RKNN Server未启动或版本不匹配;

◦解决:执行restart_rknn.sh,确保Server版本与Toolkit2一致。

1.量化后精度下降严重

◦原因:校正集不具代表性,或量化算法选择不当;

◦解决:更换KL-Divergence/MMSE算法,增加校正集数量(50-100张)。

1.模型转换报错“动态Shape不支持”

◦原因:Toolkit2 < 1.5.2 不支持动态Shape;

◦解决:升级Toolkit2到1.5.2+,用dynamic_input配置。

1.板端推理耗时比连板评估长

◦原因:连板评估有数据传输开销,板端推理更真实;

◦解决:以板端C API的eval_perf结果为准。

1.NPU Hang住(推理耗时超20s)

◦原因:驱动bug或模型超出FP16范围;

◦解决:升级NPU驱动到最新版,训练时添加BN层限制数值范围。

五、开发资源汇总

最后给大家整理了必备资源,收藏好少走弯路:

•RKNN Toolkit2:https://github.com/airockchip/rknn-toolkit2(含API文档、示例);

•RKNN Model Zoo:https://github.com/airockchip/rknn_model_zoo(MobileNet、YOLOv5等预转换模型);

•RGA库:https://github.com/airockchip/librga(图像缩放、旋转加速,配合NPU使用);

•官方文档:本文基于《RKNN SDK V2.0.0beta0用户指南》,完整文档可在瑞芯微官网下载。

总结

瑞芯微RKNPU开发的核心是“工具链熟练+优化技巧到位”:先用Toolkit2做好模型转换与评估,再根据场景选择通用/零拷贝API,最后通过多核、SRAM、动态Shape等技巧压榨性能。边缘AI部署不复杂,跟着这篇指南走,你也能快速搞定RKNPU!

如果有疑问,欢迎在评论区交流,也可以关注瑞芯微官方GitHub获取最新动态~

(附:全文核心脑图)